Tre ricercatori di Meta (Facebook) hanno appena pubblicato un articolo scientifico in cui presentano Image Decoder, un’intelligenza artificiale rivoluzionaria che sarebbe in grado di decodificare le rappresentazioni visive del cervello in pochi millisecondi.

In parole povere, se una persone è seduta in una stanza e non può vedere un’altra persona, anche se questa persona si trova dall’altra parte del mondo, il decodificatore di immagini consentirebbe alla persona seduta nella stanza di vedere cosa sta guardando l’altra persona, in base all’attività cerebrale, a condizione che la persona si trovi in una struttura di neuroimaging e sia sottoposta a scansione da una macchina MEG (magnetoencefalografo).

Catturando migliaia di misurazioni ogni secondo, i ricercatori affermano di poter visualizzare immagini corrispondenti all’attività dell’intelletto.

Nel loro articolo, i ricercatori di Meta descrivono la tecnologia alla base di Image Decoder. Si tratta essenzialmente di combinare due campi, finora in gran parte disparati: l’apprendimento automatico – in particolare il deep learning, in cui un computer apprende analizzando i dati etichettati e quindi ispezionando nuovi dati e tentando di etichettarli correttamente – e la magnetoencefalologia (MEG), un sistema che misura e registra l’attività cerebrale in modo non invasivo, al di fuori della testa, utilizzando strumenti che rilevano i piccoli cambiamenti nei campi magnetici del cervello mentre una persona pensa.

I ricercatori hanno addestrato un algoritmo di deep learning su 63.000 risultati MEG precedenti di quattro pazienti (con un’età media di 23 anni) in 12 sessioni, in cui i pazienti hanno visto 22.448 immagini uniche e 200 immagini ripetute da quel pool originale. Il team ha utilizzato DINOv2 , un modello di apprendimento progettato per addestrare altri modelli e a sua volta addestrato su scenari delle foreste del Nord America, e che Meta ha rilasciato pubblicamente nell’aprile 2023. I ricercatori hanno incaricato l’algoritmo Image Decoder di esaminare questi dati grezzi con un’immagine di ciò che la persona stava effettivamente vedendo quando il suo cervello produceva quell’attività MEG. In questo modo, confrontando i dati MEG con l’immagine sorgente reale, l’algoritmo ha imparato a decifrare quali forme e colori specifici erano rappresentati nel cervello e come.

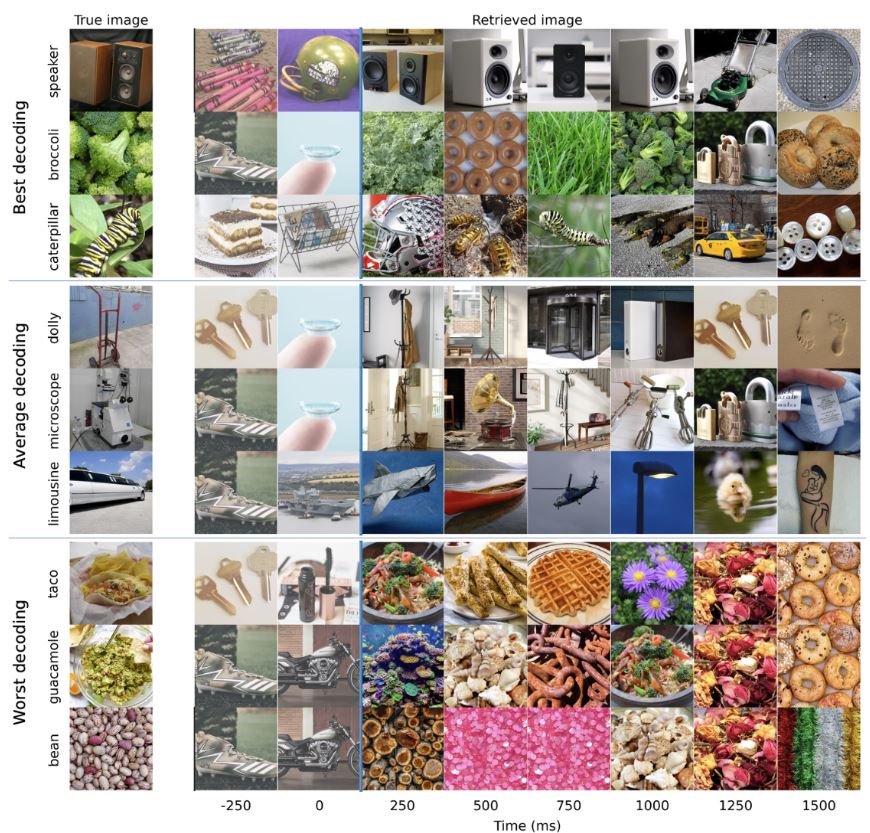

Sebbene il sistema Image Decoder sia lungi dall’essere perfetto, i ricercatori sono stati incoraggiati dai risultati, poiché ha raggiunto livelli di precisione del 70% nei casi con le prestazioni più elevate in termini di ricreazione accurata di un’immagine basata sui dati MEG, sette volte meglio di metodi esistenti.

Alcune delle immagini che il decodificatore di immagini ha recuperato con successo da un pool di potenziali immagini includevano immagini di broccoli, bruchi e altoparlanti. Ha avuto meno successo nel decodificare immagini più complesse e varie, inclusi tacos, guacamole e fagioli.

L’immagine mostra le prestazioni del decodificatore di immagini di Meta durante la decodifica di diversi dati MEG in immagini. Credito: Meta Platforms, Inc.

In una nota hanno dichiarato che “nel complesso, i risultati delineano una strada promettente per la decodifica in tempo reale delle rappresentazioni visive in laboratorio”. Tuttavia, hanno notato che la tecnologia pone “diverse considerazioni etiche”, poiché la possibilità di guardare dentro la mente di una persona rappresenta un nuovo livello di invasività che la tecnologia non ha ancora raggiunto su larga scala.

“In particolare”, tra le considerazioni etiche avanzate dai ricercatori c’è “la necessità di preservare la privacy mentale”, anche se non indicano esattamente come ciò potrebbe essere raggiunto.