L’avvento degli strumenti di intelligenza artificiale (AI) aperti al pubblico, quali ChatGPT, Bard, CoPilot, e Dall-E, segna un’era di trasformazioni radicali con un vasto potenziale di impatto positivo. Queste tecnologie promettono di rivoluzionare numerosi settori, dalla medicina, con diagnosi più precise, all’educazione, ampliando l’accesso a conoscenze specialistiche. Tuttavia, all’ombra di questi progressi, si nasconde il rischio che tali strumenti possano essere manipolati per fini malintenzionati, mettendo a rischio la sicurezza dei cittadini.

Criminali informatici, ad esempio, stanno sfruttando l’intelligenza artificiale per sviluppare chatbot avanzati che assistono in attività illecite come hacking e truffe. Il potenziale di abuso dell’IA è stato riconosciuto a livello globale, tanto che nel Regno Unito è stato introdotto il Generative AI Framework (una guida sull’Ia per i dipendenti pubblici), e il National Cyber Security Centre (centro per la sicurezza informatica) ha emesso linee guida su come le minacce online possono essere esacerbate dall’IA.

Una particolare preoccupazione riguarda la facilità con cui i criminali possono utilizzare ChatGPT e simili per orchestrare truffe di phishing altamente sofisticate e personalizzate, mirate a ingannare le persone fornendo poche informazioni iniziali. Queste tecnologie permettono di condurre frodi su vasta scala, in diverse lingue, aumentando esponenzialmente il raggio d’azione dei truffatori. Alcuni esempi già noti vedono l’uso di ChatGPT per generare ransomware (malware con riscatto da pagare) o per consigliare tecniche di hacking, evidenziando un uso distorto di strumenti progettati per fini costruttivi.

In aggiunta, stanno emergendo varianti di AI specificamente progettate per scopi dannosi, come WormGPT e FraudGPT, capaci di creare malware, identificare vulnerabilità e facilitare altre attività criminali. Love-GPT rappresenta un altro esempio inquietante, utilizzato per orchestrare truffe sentimentali su app di incontri.

Di fronte a queste minacce, organismi internazionali come Europol e agenzie nazionali come la CISA statunitense hanno lanciato avvisi sull’uso criminale dell’intelligenza artificiale, sottolineando la necessità di vigilanza.

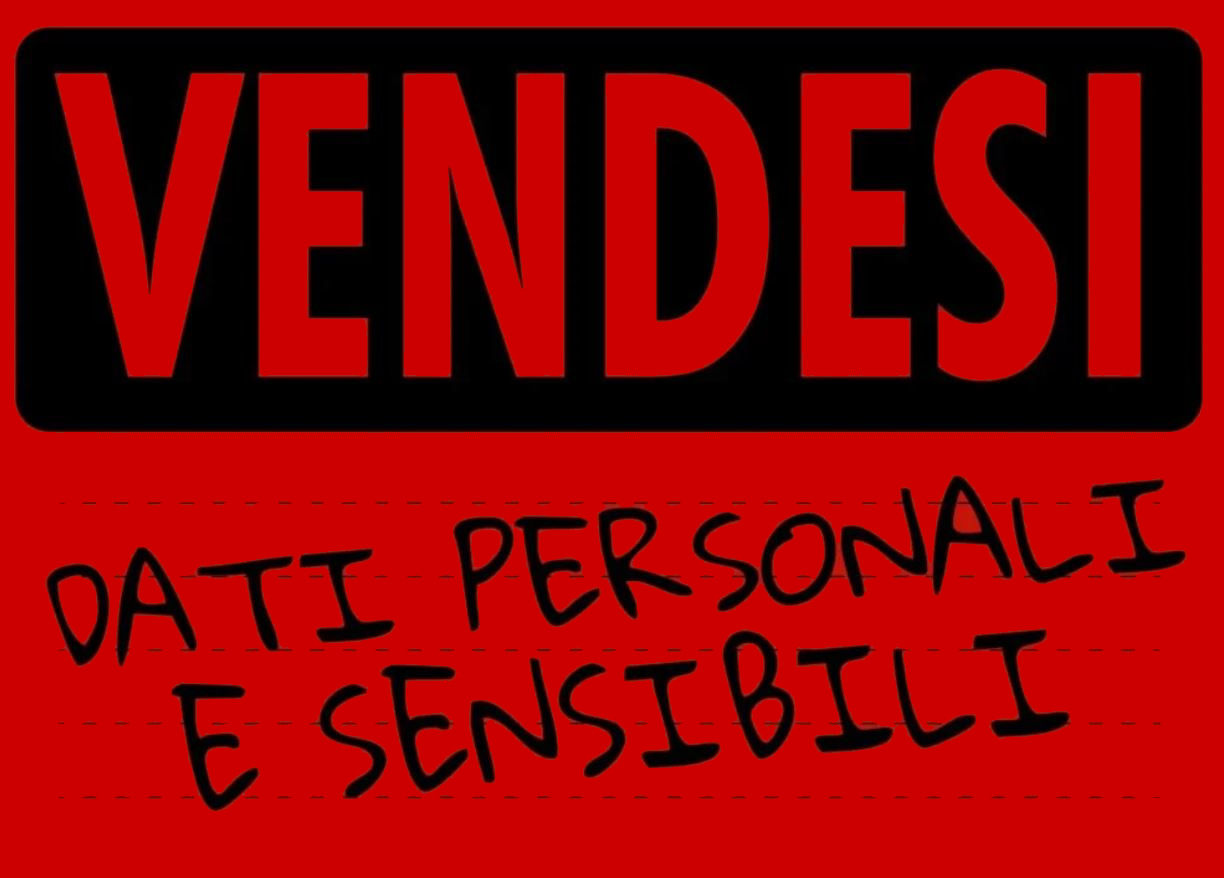

Oltre ai rischi di sicurezza, vi è anche il pericolo che le conversazioni private o dati aziendali sensibili possano essere involontariamente condivisi con questi sistemi di AI, che potrebbero poi utilizzare tali informazioni nei loro dataset di addestramento o, nel peggiore dei casi, divulgarli. La ricerca ha dimostrato come sia possibile manipolare ChatGPT per far trapelare informazioni sensibili, sollevando serie preoccupazioni sulla privacy e sulla fiducia nei confronti dell’intelligenza artificiale.

In risposta, numerose aziende di spicco hanno imposto restrizioni sull’uso di ChatGPT e tecnologie simili, riflettendo la crescente cautela nei confronti di queste potenti ma potenzialmente pericolose strumenti.

Per navigare con sicurezza nell’era dell’intelligenza artificiale, è fondamentale adottare misure di precauzione. Essere scettici nei confronti di comunicazioni che sembrano legittime ma potrebbero essere state generate artificialmente e evitare di condividere informazioni sensibili con questi sistemi sono passi critici per proteggere la propria privacy e sicurezza. Inoltre, è importante verificare le politiche del proprio datore di lavoro riguardo all’utilizzo dell’AI nel contesto lavorativo.

Mentre l’intelligenza artificiale continua a evolversi a ritmi vertiginosi, adottare un approccio cauto e informato può aiutare persone e organizzazioni a sfruttare i benefici di questa tecnologia minimizzando i rischi associati.

Foto di depositphotos