La doppia verità [1], di Claudio Poggi

In questo articolo affronterò tre argomenti:

- il Principio di Precauzione: come potrebbe/dovrebbe essere inteso, e come è invece interpretato;

- il 5G: le criticità della nuova tecnologia;

- la sistematica demolizione dell’approccio protezionistico più avanzato al mondo: quello italiano.

PRINCIPIO DI PRECAUZIONE

La prima volta accadde (a mia memoria) in un posto che difficilmente si potrebbe immaginare… il deserto sabbioso della Penisola Arabica [2], e precisamente fu quando i governanti dell’Arabia Saudita decisero che era arrivato il momento di introdurre, nello stato da loro amministrato, la telefonia cellulare.

Era infatti successo che nei pressi della capitale saudita sorgessero, ad alcuni chilometri di distanza tra loro, le antenne di Radio Riad ed un campo da calcio, nel quale accadevano le cose piu’ strane, causate dall’energia elettromagnetica “catturata” dalla tensostruttura che lo proteggeva dai raggi solari.

Non entrerò nei dettagli, basta sapere che da questa situazione i pianificatori sauditi trassero una lezione: con i Campi Elettromagnetici non si scherza.

Saggiamente dunque pensarono di valutare l’impatto della nuova tecnologia PRIMA di adottarla, quando cioè si era ancora in tempo per prendere tutte le misure precauzionali, e NON DOPO, quando sarebbe stato molto più difficile e costoso farlo.

Vennero convocati esperti, furono eseguiti lunghi ed approfonditi studi e finalmente si decise di adottare la seguente formulazione per il Principio di Precauzione: ”Un danno sospettato deve essere trattato come un danno reale, fino a prova contraria, soprattutto se tale danno riguarda la salute o la sicurezza delle persone”.

Alla luce di questo poi si procedette a progettare e realizzare la rete cellulare, con il minimo impatto possibile (veramente!) sulla popolazione.

Cosi’ si fa.

Nella civilissima ma algida Europa si preferisce esprimere il Principio di Precauzione usando una ventina di pagine, fitte fitte, in cui c’e’ tutto e il contrario di tutto, esattamente come le clausole delle assicurazioni.

Spesso viene ripetuto che deve essere tutelata la salute della popolazione, anche in caso di incertezza scientifica, ecc. ecc., ma poi, tra le righe, nascosto sotto mille parole rassicuranti si trova il vero faro guida del Principio di Precauzione europeo: “6.3.4 Esame vantaggi e oneri… L’esame dei vantaggi e degli oneri dovrebbe tuttavia comprendere un’analisi economica costi/benefici quando ciò sia adeguato e realizzabile… “.

Dunque: la salute è solo una delle cose da considerare , un’ altra è la convenienza economica. E infatti, guarda che combinazione, nel caso del Campo Elettromagnetico, come in molti altri, l’onere della prova è a carico del Cittadino…

Infine la domanda (per avere buone risposte occorre porsi buone domande): preferiamo essere tutelati dal Principio di Precauzione saudita o da quello europeo?

CRITICITÀ DEL 5G

Andando veloci, e quindi tralasciando tutti gli step intermedi, si può dire che in principio ci fu il sistema TACS, che costituì la prima generazione della telefonia mobile (1G) poi, in sequenza e a intervalli di pochi anni l’uno dall’altro, furono introdotti il GSM (2G), l’UMTS (3G), e l’LTE (4G). Erano tutte tecnologie anche molto diverse l’una dall’altra, ma che avevano in comune una cosa: ciascuna aveva qualche vantaggio rispetto alla precedente per quanto riguardava velocità, tempo di latenza, efficienza spettrale ed altre importanti caratteristiche. In poche parole, gli utenti percepivano ciascuno step come un “miglioramento” rispetto al precedente.

Il caso vuole che contemporaneamente all’introduzione del 4G, in campi diversi dalla telefonia, siano andate maturando altre tecnologie, per le quali la possibilità di “convergenza” dei servizi telefonici è apparsa subito indispensabile e foriera di grandi opportunità di guadagno.

Ad esempio l’Internet delle Cose (IoT), che è una cosa “fighissima”: vuoi mettere il frigo che ordina direttamente al supermercato, o il garage che capisce quando aprire la porta e accendere la luce, perché il tuo telefonino gli dice dove ti trovi? Tutte queste cose dovranno comunicare tra loro, ed è molto comodo che lo facciano senza dover mettere tanti fili. Certo, per trasmettere quello che deve dire il frigorifero non occorre una grandissima banda passante, ma già che ci siamo lo facciamo un collegamento ad alta velocità, vero?

Un’altra esigenza è quella delle TV, “on demand” o no qui non importa: perbacco, qui ci vuole senz’altro un collegamento ad alta velocità! E se poi la TV vogliamo vederla anche sul treno o in auto come minimo occorre anche un basso tempo di latenza… di bene in meglio!

E, già che ci siamo, perché non risolvere anche il problema dell’ultimo miglio? Un buon collegamento radio e si eliminano tutti i problemi di cablaggio, sostituendoli con un sistema moderno, rapido, che non sporca, non ingombra, non si vede.

Insomma dopo il 4G qualcuno ha deciso che NON BASTA la solita transizione verso una tecnologia un po’ più performante, ma occorre realizzare una vera e propria RIVOLUZIONE: qualcosa che possa gestire tutto assieme: IoT, trasmissione verso mezzi anche ad altissima velocità (anche a 500 Km/h! [3]), enorme bit rate (per i video), frequenze diverse, e via dicendo.

In definitiva: una cosa molto sofisticata (quindi appannaggio di POCHI COSTRUTTORI), molto costosa, ma anche molto performante e, potenzialmente, MOLTO MOLTO MOLTO REDDITIZIA per coloro che la realizzano (operando quasi in condizione di MERCATO CHIUSO), e per i provider.

Fin qui ci siamo, ma a prezzo di quale IMPATTO AMBIENTALE?

Per vari motivi tecnici, quanto più si vuole trasmettere velocemente tanto più occorre potenza (per chi ha un po’ di dimestichezza con la materia: i “simboli” della “costellazione” devono essere più spaziati).

Questo fatto rappresenta la prima criticità del 5G: se il collegamento lo vogliamo ad ALTA VELOCITÀ e non vogliamo usare per es. la fibra ottica, allora dobbiamo sapere che dovremo mandare in giro un bel po’ di POTENZA.

Ma non basta: per consentire l’accesso a molti utenti occorrono molte piccole celle, (riuso delle frequenze), e quindi una distribuzione CAPILLARE dei trasmettitori. Davvero abbiamo bisogno di una rete di trasmettitori a microonde ad ogni angolo di strada, il cui segnale per giunta si SOVRAPPONGA a tutti i segnali che già esistono?

Sicuramente con il 5G si verificherà un incremento del livello di elettrosmog, e quindi si renderà necessario un ulteriore rilassamento dei limiti protezionistici, i quali, lo ricordiamo, furono già gravemente depotenziati dal mai abbastanza deprecato Monti, che si inventò la misura mediata su 24 ore per vendere più facilmente le frequenze necessarie alla rete LTE (più o meno come se le multe per eccesso di velocità fossero fatte non considerando la velocità istantanea rilevata, ma la velocità media calcolata nell’arco dell’intera giornata, contando anche le ore in cui l’auto è parcheggiata: tutto legale, ma anche TUTTO INUTILE).

I primi due punti illustrati: Principio di Precauzione e Criticità del 5G, ci portano inevitabilmente al nocciolo della questione, che è:

LA DOPPIA VERITÀ, OVVERO: LA NECESSARIA DEMOLIZIONE DELL’APPROCCIO PROTEZIONISTICO ITALIANO

Di fianco al portatile con cui sto scrivendo questa nota, ho una caraffa di acqua fresca, e ogni tanto ne bevo un sorso. L’acqua del rubinetto, a Genova, è eccellente, ma come faccio ad essere sicuro che non ci sia un livello troppo elevato di qualche sostanza dannosa, ad es. di arsenico?

Semplice, me lo assicura il D.Lgs 31/2001 che, per l’arsenico, stabilisce il LIMITE MASSIMO di 10 µg/L (microgrammi/litro).

Infatti funziona così: la salubrità della mia acqua, come di tutti gli altri alimenti, viene garantita stabilendo LIMITI ALLA POTENZIALE FONTE DI INQUINAMENTO.

Chiunque si prendesse cura della mia salute ponendo invece dei limiti che considerino quanto io possa essere esposto -in via del tutto teorica- ad un certo inquinante, senza dubbio sarebbe dichiarato da tutti o ignorante o in malafede!

In altre parole: non si può permettere che il contenuto dell’arsenico nella mia caraffa d’acqua possa essere elevato, solo perché si suppone che io ne beva soltanto un bicchiere. E se avessi tanta sete? Oppure, se ne bevessi un bicchiere, ma il mio organismo fosse molto sensibile all’arsenico?

Quello che non si può concepire per gli alimenti, chissà per quale ragione, ci viene propinato come ragionevole quando si parla di inquinamento elettromagnetico.

Infatti non solo i costruttori, ma anche le istituzioni, nel tentativo di disinnescare la diffusa preoccupazione per i Campi Elettromagnetici emessi dai telefonini, ci ammanniscono il solito gioco di prestigio del SAR [4] il quale, tra le varie assurdità che porta con sé, ne ha almeno due molto gravi (per chi volesse saperne di più [5]):

non tiene conto degli effetti a lungo termine, dato che considera semplicemente la “potenza assorbita”;

non può tener conto delle diversità tra individui.

Quanto abbiamo visto è già una DOPPIA VERITÀ: da una parte il voler limitare l’inquinamento ALLA SORGENTE, dall’altra volerlo considerare (col SAR) un dato in relazione a colui che SUBISCE l’inquinamento. La prima forma di protezione è applicata in quasi tutti i settori, ma non all’elettrosmog; la seconda ignora la logica ed è basata sulle esigenze dell’industria. Guarda caso, all’elettrosmog viene applicata proprio quest’ultima forma.

Ma ne esiste un’altra, ben più grave, che riguarda le modalità di azione del Campo Elettromagnetico, e quindi, di protezione dai suoi effetti.

La pretesa di considerare non l’esposizione delle persone al campo elettromagnetico ma la potenza specifica assorbita (SAR) è conseguenza del postulato secondo cui l’unica interazione delle microonde con la materia vivente è l’interazione termica, cioè il trasferimento di energia dal campo alla materia sotto forma di calore (unicità dell’effetto termico).

Ma l’interazione può avvenire, in generale, attraverso altri canali o gradi di libertà, ad esempio attraverso lo stesso canale elettromagnetico. Ciò deve essere evidentemente possibile perché il corpo è un sistema materico ma anche elettromagnetico, come risulta evidente dall’ECG e dall’EEG (vedi anche [6]).

Dunque, il postulato dell’ “unicità dell’ EFFETTO TERMICO” è DESTITUITO DI FONDAMENTO.

Eppure è QUESTO il postulato che l’OMS, gli Stati Uniti, attraverso la Federal Commition for Communication (che regola la materia con una Norma tecnica adottata nel 1996), e l’Unione Europea (con la Raccomandazione 1999/519/CE e la direttiva 2013/35/UE), hanno adottato ed imposto alle popolazioni angloamericane e dell’UE.

Sulla base di tale postulato, OMS, USA ed UE affermano che i limiti di SAR e di esposizione imposti, formulati dall’associazione delle industrie elettriche ed elettroniche americane (std. IEEE C95-2, 1992) sono adeguati, perché sufficienti a proteggere il corpo umano da aumenti di temperatura di 1 °C ed oltre.

Come possono dire questo? Perchè sostengono la LORO VERITÀ e cioè che gli effetti conseguenti a tale aumento di temperatura sono gli unici accertati.

Ma per fare questo negano un’altra VERITA’, accertata in decine di migliaia di studi scientifici, che segnalano effetti dannosi “non termici” (senza incremento significativo di temperatura).

Con quale argomento? Gli studi che riportano effetti non termici avversi sono quasi tutti studi in vitro o epidemiologici, validi a stabilire un nesso di “possibilità causale” non di “necessità causale”.

Per stabilire un nesso di causalità certa occorre che a riportare effetti avversi non termici siano studi in vivo o studi clinici.

Tale NESSO DI CAUSALITÀ’ CERTA è stato stabilito recentemente con gli studi del National Toxicology Program degli N.I H. USA e dell’Istituto Ramazzini di Bologna che hanno evidenziato il nesso causale tra esposizione a microonde, al di sotto della soglia termica (0,5 W/kg per i topi e 0,6 W/kg per i ratti) e insorgenza tumorale, e questo è certamente un effetto non termico, dal momento che l’incubazione tumorale è un effetto rilevabile in mesi o anni, mentre l’aumento della temperatura di 1°C è un effetto che si rivela in tempi dell’ordine dei minuti (grazie all’omeostasi del sangue).

Nonostante ciò l’OMS, la Commissione UE e la FCC USA OMETTONO di prendere in considerazione la verità che contrasta con gli interessi dei grandi gruppi industriali.

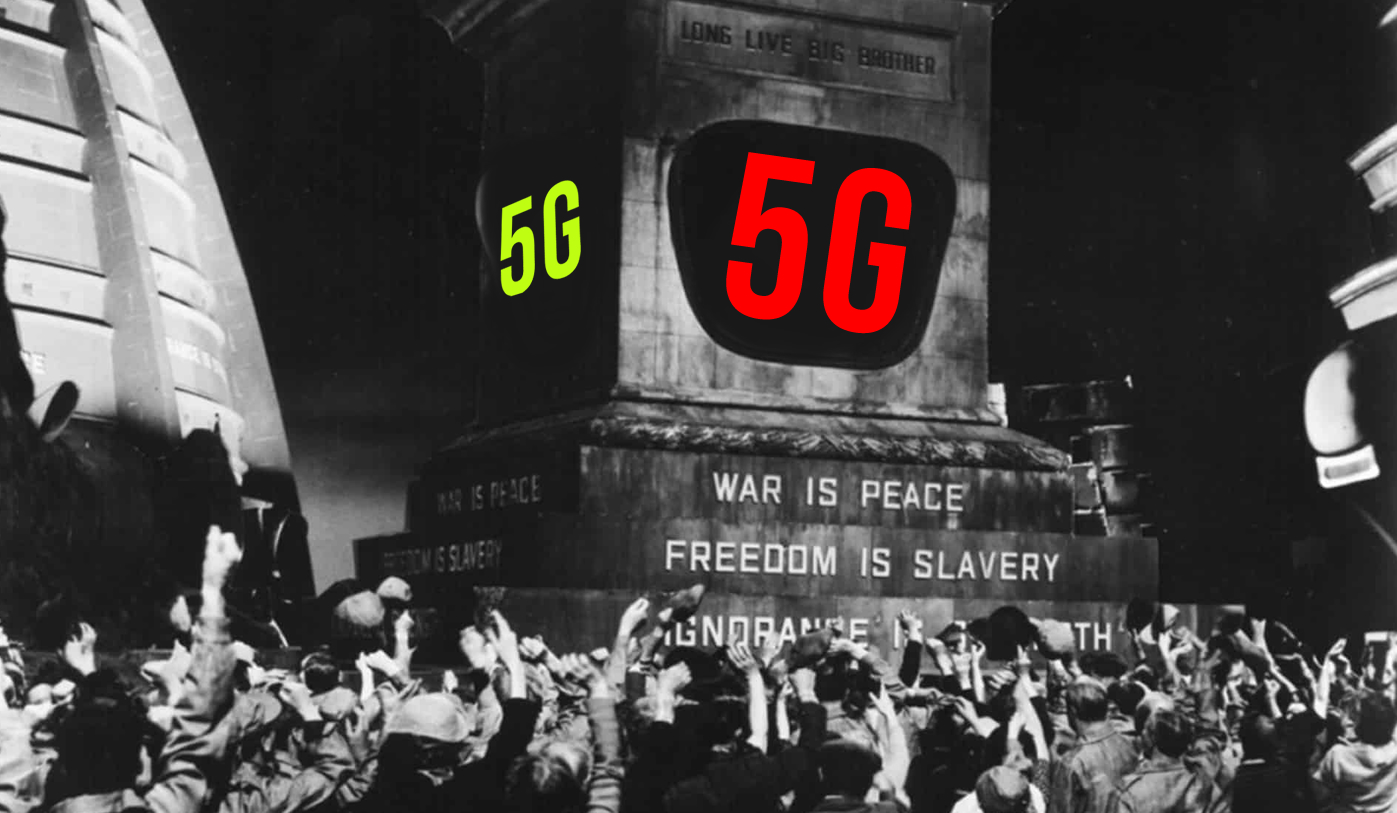

Ma il fatto che mostra l’inverarsi della profezia di “double thinking” di Orwell è che, in presenza di interessi economici dell’ industria degli elettromedicali, l’agenzia americana Food and Drug Administration abbia rilasciato la certificazione di mezzo terapeutico per il tumore al cervello, alternativo alla radioterapia, al dispositivo Optune della Novocure Ltd., generatore di onde elettromagnetiche “non termiche” (centinaia di volte al di sotto della soglia termica) nella banda delle onde radio lunghe. Dunque, in USA negli anni dieci di questo secolo, nell’ambito di competenza della FCC non esistono effetti non termici accertati sull’uomo delle esposizioni ai campi elettromagnetici nella banda delle radiofrequenze (3 kHz – 30 GHz), ma nel campo di competenza della FDA gli effetti non termici delle radiofrequenze esistono eccome! E sono in grado di curare i tumori al cervello!

Pertanto:

- se il Principio di Precauzione è formulato in modo da tutelare gli interessi industriali;

- se il 5G è una tecnologia molto “invadente”, che si sovrapporrà a tutte quelle già esistenti, producendo inevitabilmente un aumento dell’inquinamento elettromagnetico;

- se, come visto, siamo in regime di “doppia verità”, in cui, a seconda delle convenienze industriali si fa valere tutto e anche il suo contrario, contemporaneamente,

allora l’ultima cosa che rimane a tutela dei Cittadini sembrano proprio essere il LIMITE DEI 6V/m e il “METODO DELLA LIMITAZIONE DELLA SORGENTE”, adottati dal sistema protezionistico italiano [7], magari abolendo i “miglioramenti” escogitati prima dal professore bocconiano [8], e poi dai governi che gli sono succeduti.

E invece, se si procederà con il 5G, sarà NECESSARIO o abolire o modificare pesantemente il sistema protezionistico italiano.

Dico queste cose perché anche io, come tutti, e anche per attitudine e mestiere, voglio “andare avanti”, ma spesso chi lo dice mi pare indichi la direzione opposta, quella cioè in cui per andare si va, si, è vero, ma “indietro”…

L’AUTORE

Claudio Poggi è laureato in Ingegneria Elettronica al Dipartimento di Ingegneria Biofisica ed Elettronica dell’Università di Genova, e da 35 anni si occupa della progettazione di apparecchiature elettroniche, spesso elettromedicali, e delle problematiche inerenti i Campi Elettromagnetici. http://www.claudiopoggi.it

[1] Il “doublethink” (“Bispensiero”) è stato preconizzato da Orwell come caratterizzante le società totalitarie. https://it.wikipedia.org/wiki/Bispensiero.

[3] Kalid Nabulsi, Said El-Khamy “Towards Setting Non-Ionizing Radiation Safety Standards for Saudi Arabia”. Dept of Electrical and Computer Engineering, College of Engineering, King Abdulazis University. Jeddah, Saudi Arabia.

[3] Minimum requirements related to technical performance for IMT-2020 radio interfaces (ITU).

[3] SAR: acronimo di “Specific Absorption Rate” (ovvero “tasso di assorbimento specifico”), misura la quantità di energia elettromagnetica che viene assorbita nell’unità di tempo dalla massa unitaria di un organismo biologico e si esprime in W/kg.

[3] maggiori considerazioni sul SAR si trovano a questo link.

[6] penso sia sbagliato considerare il corpo umano solo dal punto di vista “chimico” (cfr. con : l’ Uomo Elettromagnetico).

[7] La cornice scientifica relativa alla “limitazione della sorgente” fu per la prima volta presentata dal Dott. Livio Giuliani al XXX Congresso Nazionale dell’AIRM (Assoc. It. di Radioprotezione Medica), Cavalese, nel Febbraio 1998 e poi inserita nella “Proposta Aggiuntiva dell’Ispesl” al “Documento Congiunto Ispesl-ISS sulle Problematiche della Esposizione delle Lavoratrici e dei Lavoratori e della Popolazione ai campi elettrici, magnetici ed elettromagnetici di frequenza compresa tra 0 Hz e 300 GHz”, pubblicata su Fogli d’Informazione ISPESL 1997, S(4).

[8] Il regolamento indicante i limiti di radiofrequenza compatibili con la salute umana, DM 10 settembre 1998 n. 381, confermato dal decreto non regolamentare DPCM 8/7/2003 GU S.G.n. 199/2003, è stato modicato da Monti, con d.l. 179/2012, che con l’art. 14 comma 8, ha introdotto la media di 24 ore per misurare il limite di esposizione di 6 V/m valido per esposizioni di 4 ore di cui all’art. 4 DPCM 8/7/2003. Però il diavolo fa le pentole ma non i coperti, e non si e accorto di aver modificato un decreto non regolamentare lasciando in vigore il regolamento. Ci auguriamo che l’attuale Governo sappia reintrodurre a livello esecutivo il rispetto del limite di 6 V/m come previsto dal vigente Regolamento DM 381/1998.