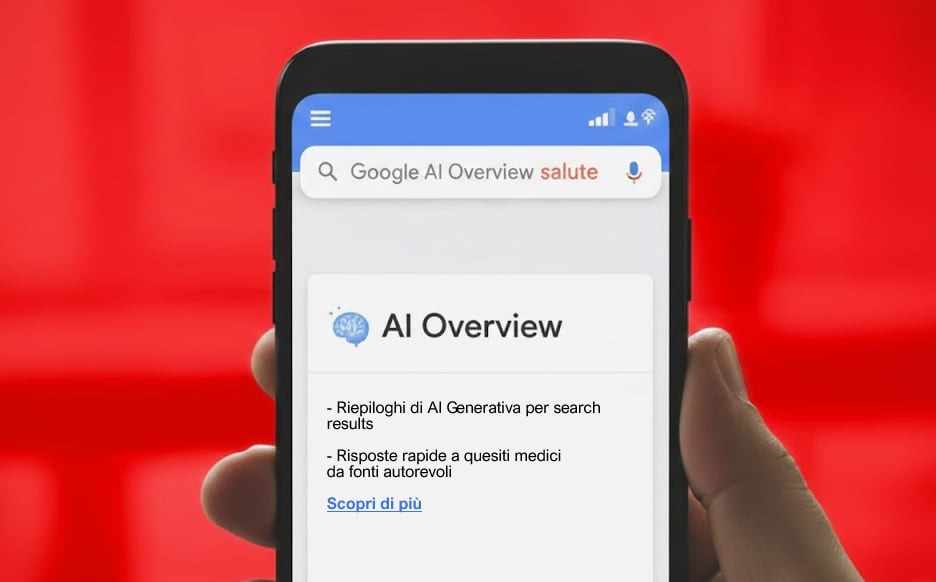

Quando oggi si fa una ricerca su Google, spesso, prima dei risultati, in alto compare un riquadro che riassume la risposta alla domanda usando l’intelligenza artificiale. Google lo chiama AI Overview; è una sintesi automatica che prende informazioni da varie fonti online e le presenta come una risposta pronta, apparentemente ordinata e rassicurante. Ecco di seguito come appare dai dispostivi mobili:

“Cosa mangiare con il colesterolo alto”? Prima ancora di leggere articoli o siti medici, Google ti mostra un testo che elenca cibi consigliati e cibi da evitare. Molti utenti si fermano lì, non cliccano altro. Quel riquadro diventa di fatto il medico, il nutrizionista o il consulente sanitario.

È proprio qui che nasce il problema raccontato da un’inchiesta di The Guardian. Secondo l’indagine, alcune panoramiche AI di Google in ambito sanitario contengono informazioni false o fuorvianti che possono mettere a rischio la salute delle persone.

In un caso giudicato molto pericoloso dagli esperti, Google ha suggerito ai pazienti con cancro al pancreas di evitare i cibi ricchi di grassi. È l’opposto di ciò che viene raccomandato nella pratica clinica. Le persone con questo tipo di tumore hanno spesso bisogno di un apporto calorico elevato per mantenere il peso e riuscire a tollerare terapie come chemioterapia o interventi chirurgici. Seguire quel consiglio può indebolire il corpo e ridurre le possibilità di cura.

Altri esempi riguardano gli esami del fegato. Cercando online quale sia il range normale dei valori epatici, l’AI Overview mostrava numeri senza spiegazioni, senza contesto e senza considerare età, sesso o provenienza geografica. Secondo le organizzazioni sanitarie questo può portare persone con malattie epatiche serie a credere di avere esami normali e a rinviare controlli fondamentali.

Anche le ricerche sui tumori femminili hanno prodotto risultati errati. In alcuni casi il pap test veniva indicato come esame per il cancro vaginale…Non lo è. Chi riceve un’informazione di questo tipo potrebbe ignorare sintomi reali pensando di essere al sicuro dopo uno screening che in realtà serve a tutt’altro.

L’inchiesta ha rilevato risposte fuorvianti anche su disturbi della salute mentale, con suggerimenti considerati dannosi o tali da scoraggiare le persone dal chiedere aiuto professionale. Di fronte alle criticità emerse, Google ha respinto le accuse. Un portavoce dell’azienda ha affermato che molti degli esempi sanitari condivisi erano “screenshot incompleti”, ma che da quanto hanno potuto valutare le panoramiche “hanno collegato fonti note e affidabili e hanno raccomandato di chiedere consiglio a un esperto”.

L’azienda ha inoltre dichiarato che “la stragrande maggioranza delle sue panoramiche basate sull’intelligenza artificiale era concreta e utile” e che il tasso di accuratezza delle AI Overview è “in linea con quello delle altre funzionalità di ricerca, come gli snippet in primo piano, presenti da oltre un decennio”.

Google ha anche spiegato che “qualora AI Overview interpretasse male i contenuti web o non cogliesse il contesto, avrebbe preso le misure appropriate in base alle sue politiche”. In una dichiarazione finale, un portavoce ha aggiunto: “Investiamo in modo significativo nella qualità delle panoramiche basate sull’intelligenza artificiale, in particolare per argomenti come la salute, e la stragrande maggioranza fornisce informazioni accurate”.

Quando si tratta di salute, poche righe generate da un algoritmo non possono sostituire il contesto, la competenza e il confronto con un medico. Usatele per orientarvi magari, non per decidere della vostra salute. Quando un motore di ricerca sbaglia, a pagare non è l’algoritmo siete voi…