Secondo gli scienziati, l’ipotesi che un’intelligenza artificiale possa prendere il sopravvento sull’umanità non è assolutamente plausibile. Una nuova ricerca dell’Università di Oxford suggerisce che il cervello umano apprende le informazioni in un modo fondamentalmente diverso e più efficiente rispetto alle macchine.

Mentre gli esseri umani imparano qualcosa dopo averlo visto una volta, l’intelligenza artificiale deve essere addestrata centinaia di volte sulla stessa informazione. A differenza dell’intelligenza artificiale, gli esseri umani possono anche apprendere nuove informazioni senza che queste interferiscano con la conoscenza che già si possiede.

Uno dei processi fondamentali dell’apprendimento è qualcosa chiamato ‘assegnazione di crediti‘. Quando commettiamo un errore, l’assegnazione del credito cerca di capire in quale punto del processo di elaborazione delle informazioni si è introdotto l’errore.

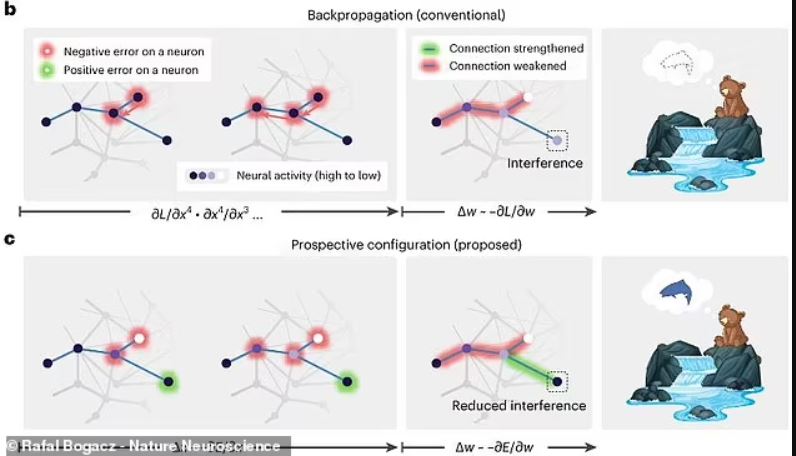

La maggior parte dell’intelligenza artificiale moderna è costituita da reti neurali artificiali, che sono strati di “nodi” o neuroni simili a quelli che potremmo trovare nel cervello. Quando un’intelligenza artificiale commette un errore, regola le connessioni tra questi neuroni, detta anche regolazione dei “pesi”, per mettere a punto i suoi processi decisionali finché non ottiene la risposta giusta. Questo processo è chiamato backpropagation (Retropropagazione dell’errore) perché gli errori si propagano all’indietro attraverso la rete neurale dell’IA.

Fino a poco tempo fa, molti ricercatori pensavano che questo fosse il modo in cui le reti neurali biologiche come il cervello umano imparassero da nuove esperienze. Nel loro articolo, pubblicato su Nature Neuroscience, gli autori scrivono: “La backpropagation, come teoria semplice ma efficace per l’assegnazione dei crediti, ha alimentato notevoli progressi nell’intelligenza artificiale sin dal suo inizio e ha anche guadagnato un posto predominante nella comprensione dell’apprendimento nel cervello.“

Tuttavia, sottolineano anche che il cervello è superiore alle IA che utilizzano la backpropagation, in una serie di modi importanti. Sebbene l’intelligenza artificiale possa sovraperformare gli esseri umani in compiti che vanno dal pensiero creativo all’assunzione del personale, ci vuole molto tempo prima che l’intelligenza artificiale impari a farlo.

Gli esseri umani sono in grado di imparare da un singolo esempio di una nuova esperienza, mentre l’intelligenza artificiale deve essere esposta a centinaia di esempi, se non migliaia di volte. E, cosa molto importante, quando gli esseri umani imparano qualcosa di nuovo non interferisce con ciò che già sappiamo, mentre questo è il caso dell’intelligenza artificiale.

Di fronte a queste prove, i ricercatori hanno esaminato le serie di equazioni che descrivono come cambia il comportamento dei neuroni nel cervello. Quando hanno simulato questi metodi di elaborazione delle informazioni, hanno scoperto che si trattava di un modo completamente diverso di apprendere la backpropagation, che chiamano prospective configuration (configurazione prospettica).

A differenza dell’intelligenza artificiale, che prima regola le connessioni tra i neuroni, l’attività dei neuroni cambia in modo che possano prevedere meglio il risultato, quindi i pesi vengono adeguati per adattarsi a questo nuovo modello. Anche se questa potrebbe non sembrare una differenza importante, gli effetti possono essere molto significativi. Ad esempio, i ricercatori descrivono un orso che va a caccia di pesci.

Quando l’orso vede il fiume, la sua mente genera previsioni sull’udito dell’acqua e sull’odore del salmone. Quando tutto funziona bene, l’orso può dedurre che dovrebbe essere in grado di sentire l’odore del salmone nel fiume quando lo vede, e quindi sa dove cacciare. Ma ipotizziamo che un giorno l’orso viene a pescare e si è ferito all’orecchio tanto da non poter più sentire il fiume. Se l’orso utilizzasse un metodo di apprendimento simile all’intelligenza artificiale, la propagazione all’indietro invierebbe questo errore – la mancanza di udito – per ridurre la connessione tra vedere e sentire il fiume. Ma ciò ridurrebbe anche il peso tra vedere il fiume e annusare il pesce. L’orso quindi non riuscirebbe a prevedere che può sentire l’odore del pesce quando arriva al fiume e quindi concluderebbe che non ci sono salmoni nel fiume.

Questo diagramma mostra come per un’intelligenza artificiale (in alto) se l’orso perdesse l’udito predirebbe che non ci sono pesci, mentre un cervello biologico (in basso) farebbe comunque la previsione corretta.

Ma, anche se la configurazione prospettica è un modo più efficiente di apprendimento, gli scienziati affermano che i computer attuali non possono utilizzare questo tipo di sistema.

Il primo autore dello studio, il dottor Yuhang Song, afferma: “La simulazione della configurazione futura sui computer esistenti è lenta, perché funzionano in modi fondamentalmente diversi dal cervello biologico”. Tuttavia, il dottor Song afferma che esiste la possibilità di sviluppare nuovi computer che potrebbero utilizzare questo metodo. E aggiunge: “È necessario sviluppare un nuovo tipo di computer o di hardware dedicato ispirato al cervello, che sarà in grado di implementare la configurazione potenziale rapidamente e con un minimo consumo di energia.”

La ricerca futura mirerà a colmare il divario tra algoritmi e cervelli reali.