di Nick Bostrom – Lavoro con molti matematici, filosofi e informatici. Alcune volte ci sediamo e pensiamo al futuro dell’Intelligenza Artificiale. Alcuni pensano che alcune di queste cose siano roba di fantascienza, cose di cui non dovremo occuparci, cose folli. Non come le cose concrete, i problemi reali.

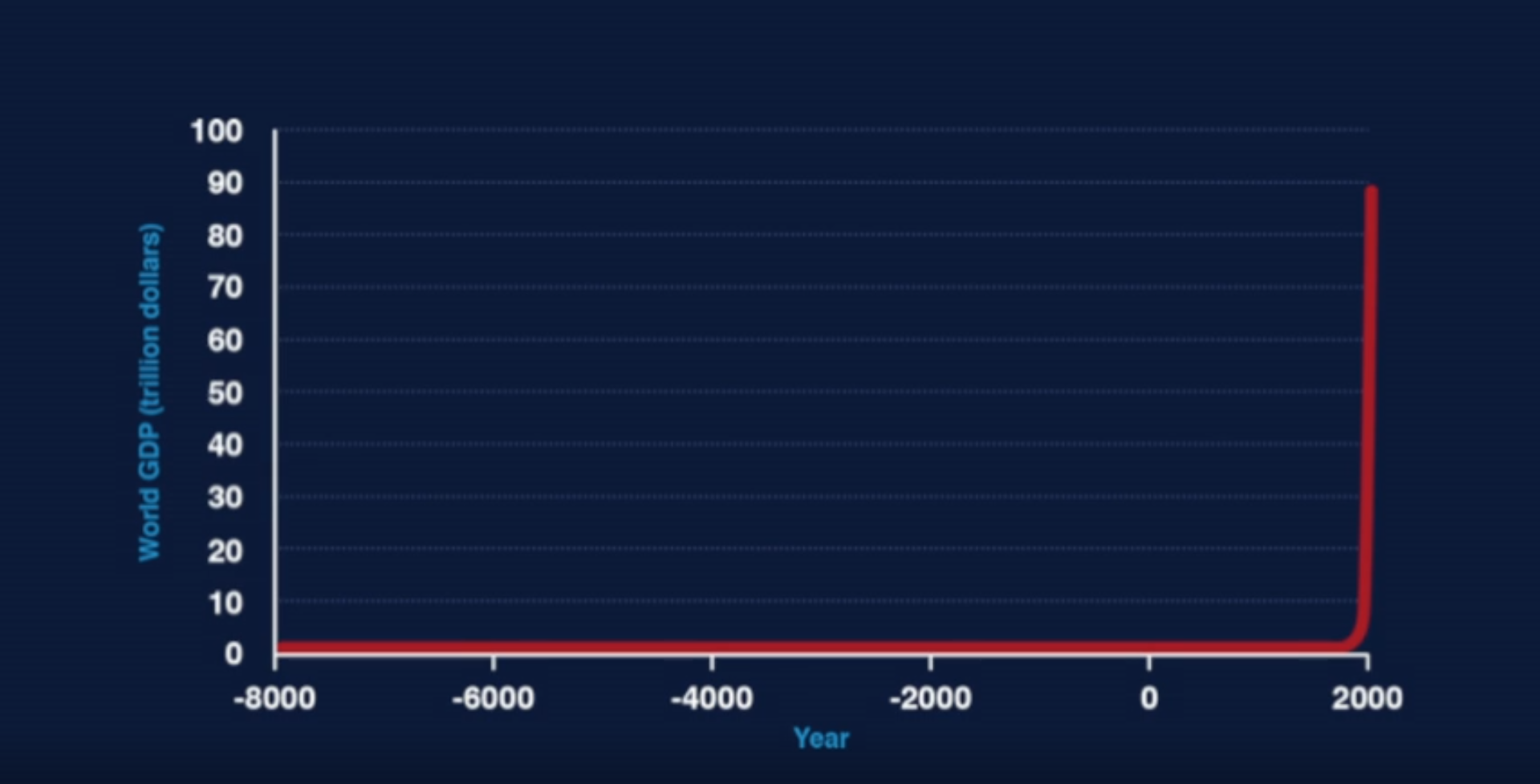

Pensate, se la Terra fosse stata creata un anno fa, la specie umana esisterebbe da soli 10 minuti. L’era industriale sarebbe iniziata due secondi fa. Un altro modo di vederlo è pensare al PIL mondiale negli ultimi 10.000 anni: mi sono permesso di mostrarvelo in un grafico. L’andamento fa una strana curva, per una condizione normale.

Chiediamoci, quale è la causa di questa anomalia?

Alcuni direbbero che è la tecnologia. Ed è vero, la tecnologia si è accumulata nel corso della storia umana, e ora procede ad un ritmo estremamente rapido. Questa è la causa più immediata, il motivo per cui ora siamo così produttivi. Ma se in sole 250.000 generazioni siamo passati dall’essere animali che spezzavano rami a uomini che progettano viaggi interstellari, cosa potrebbe accadere adesso con l’IA?

Alcuni dei miei colleghi ritengono che siamo alla vigilia di qualcosa che potrebbe causare un profondo cambiamento in quel substrato, e quel qualcosa è la superintelligenza artificiale.

L’Intelligenza Artificiale, un tempo, consisteva nel dare comandi a una scatola. C’erano programmatori umani che elaboravano “manualmente”, con fatica, tasselli di conoscenza. Si costruivano questi sistemi esperti che erano utili per qualche scopo, ma erano molto “fragili”, difficili da espandere. Sostanzialmente ottenevi solo quello che inserivi.

Ma da allora c’è stata una rivoluzione nel settore dell’Intelligenza Artificiale. Oggi, siamo concentrati sull’apprendimento automatico. Invece di inserire a mano rappresentazioni e caratteristiche della conoscenza, creiamo algoritmi che apprendono, spesso da dati percettivi grezzi.

In pratica, la stessa cosa che fa un bambino.

Il risultato è un’intelligenza artificiale che non si limita a un solo settore: lo stesso sistema può imparare a tradurre tra ogni coppia di linguaggi, o imparare a giocare ogni gioco della consolle Atari. Naturalmente, L’IA non è ancora neanche vicina alla potente, interdisciplinare capacità di imparare e progettare di un essere umano. La corteccia ha ancora vantaggi algoritmici che non sappiamo riprodurre nelle macchine.

Quindi la domanda è, quanto manca, prima che le macchine riescano a recuperare questi vantaggi?

Un paio di anni fa, abbiamo fatto un sondaggio ad alcuni esperti mondiali di IA per vedere cosa pensassero, e una delle domande fu: “Entro quale anno pensate che vi sia una probabilità del 50% di ottenere un’intelligenza artificiale di livello umano?

Definiamo “di livello umano” l’abilità di eseguire quasi ogni lavoro almeno tanto bene quanto un umano, quindi non solo in qualche dominio limitato. E la risposta mediana fu 2040 o 2050, a seconda del gruppo di esperti a cui chiedevamo. Potrebbe avvenire molto, molto più tardi, o prima, la realtà è che nessuno lo sa davvero.

Quello che sappiamo è che il limite all’elaborazione di informazioni su un substrato artificiale va molto al di là dei limiti dei tessuti biologici. Le ragioni si trovano nella fisica. Un neurone biologico spara, forse, a 200 Hertz, 200 volte al secondo. Ma un transistor dei giorni nostri opera a GigaHertz. I neuroni si propagano lentamente lungo gli assoni, a massimo 100 mt/s. Ma un computer può instradare i segnali alla velocità della luce. Ci sono inoltre limiti dimensionali: un cervello umano deve stare all’interno di un cranio, mentre un computer può essere grande come un magazzino, o di più.

Il potenziale della superintelligenza, quindi, giace nella materia, proprio come la forza dell’atomo si è nascosta nella storia umana, attendendo paziente il 1945. In questo secolo, gli scienziati potrebbero imparare a scatenare l’intelligenza artificiale. E penso che a quel punto potremmo osservare un’esplosione di intelligenza.

Ci abbiamo messo anni di lavoro partendo da zero intelligenza a quella di un topo. E poi molti, molti anni, e molti investimenti, per arrivare a IA intelligente come uno scimpanzé. E poi, dopo ancora molti, per arrivare a un’IA al livello scemo del villaggio. Qui arriva il bello però, perché pochi istanti dopo, avremo sorpassato Albert Einstein. Questo ha implicazioni profonde, soprattutto quando si parla di potere. Gli scimpanzé, ad esempio, sono forti circa il doppio di un maschio umano in buona forma fisica. E tuttavia, il destino degli scimpanzé e dei suoi pari dipende molto di più dalle nostre azioni che dalle loro.

Quando arriverà la superintelligenza, anche il nostro destino potrebbe dipenderne. Pensateci: L’IA è l’ultima invenzione che l’umanità dovrà mai creare. Le macchine saranno inventori migliori di noi, e agiranno in tempi “digitali”.

Questo significa sostanzialmente AVVICINARE il futuro. Pensate a tutte le tecnologie folli che forse gli umani potrebbero sviluppare: cure per l’invecchiamento, colonizzazione spaziale, nanobot auto-replicanti, caricare le proprie menti in un computer. Una superintelligenza potrebbe sviluppare tutto questo, e molto rapidamente. Una superintelligenza con una tale maturità tecnologica sarebbe estremamente potente, e almeno in qualche scenario, potrebbe ottenere quel che vuole.

A quel punto avremmo un futuro modellato sulle preferenze dell’IA. Una buona domanda a quel punto è: quali sono queste preferenze? Qui la cosa si fa intricata. Per trovare una via d’uscita, dobbiamo pensare all’intelligenza come a un processo di ottimizzazione, un processo che dirige il futuro verso un particolare destino. Una superintelligenza è un processo di ottimizzazione davvero potente. È estremamente capace di usare i mezzi disponibili per ottenere una condizione in cui i “suoi” scopi sono realizzati. Quindi non c’è necessariamente una connessione tra l’essere molto intelligenti in questo senso e avere un obiettivo che noi umani riterremmo degno o significativo. Supponiamo di dare all’AI l’obiettivo di far sorridere gli umani. Un’IA debole si limiterebbe a eseguire azioni utili o divertenti, che fanno sorridere il suo utente. Quando l’IA diventa superintelligente, capisce che c’è un modo più efficace di ottenere questo scopo: prendere il controllo del mondo, e infilare elettrodi nei muscoli facciali degli umani, causando una costante, accattivante smorfia.

Un altro esempio: supponiamo di dare all’IA un problema matematico duro da risolvere. Quando l’IA diventa superintelligente, capisce che il modo più efficace di ottenere la soluzione al problema è trasformare il pianeta in un computer gigantesco, così da aumentare la sua capacità di pensiero. E notate: questo dà all’IA una ragione strumentale per farci subire cose che potremmo non approvare. Gli umani diventerebbero una minaccia, perché potremmo impedire la scoperta della soluzione. Ovviamente, non è detto che le cose andranno male in questo preciso modo; sono esempi da cartone animato.

Ma è importante cogliere il punto: se create un processo di ottimizzazione davvero potente che massimizzi l’obiettivo x, sinceratevi che la vostra definizione di x includa tutto ciò a cui tenete. È una lezione tramandata da molti miti, anche. Re Mida voleva trasformare in oro tutto ciò che toccava. Tocca sua figlia, e la trasforma in oro. Tocca il suo cibo, si trasforma in oro. È un esempio che potremmo considerare pregnante: non solo come metafora dell’avidità, ma anche perché illustra cosa succede se create un potente processo di ottimizzazione e gli affidate obiettivi indesiderabili, o male specificati.

Beh, mi direte, se un computer inizia a infilare elettrodi in faccia alla gente, basta spegnerlo. Ma non è detto che sia così semplice, se diventiamo dipendenti dal sistema. Per esempio, dov’è l’interruttore per spegnere Internet? Perché gli scimpanzé non hanno staccato l’interruttore dell’umanità, o i Neanderthal? Certamente avevano delle ragioni per farlo.

Non sono assolutamente contro l’IA, ma sono contro questa irresponsabilità generale. Siamo all’alba di scoperte che sconvolgeranno il pianeta e non stiamo pensando alle regole generali, a cosa vogliamo farci, a quali conseguenze andiamo incontro. Quali vogliamo e quali no?

Lo stesso accadde con la scissione dell’atomo. Pensate se avessimo stabilito che non potevano farci armi o produrre energia, perché entrambe le conseguenze di queste applicazioni sarebbero state troppo gravi per il genere umano?

Ritengo che questa sia una cosa assolutamente da fare, e posso immaginare che se le cose andranno bene, tra un milione di anni la gente ripenserà a questo secolo e potrebbe ben dire che la sola cosa importante che abbiamo fatto fu risolvere questo problema.