di Karen Hao – L’etica è troppo soggettiva per guidare l’uso dell’IA (Intelligenza Artificiale), questo è quello che sostengono alcuni studiosi di diritto. Non c’è un qualcosa che è “giusto” o “sbagliato” per natura.

Quindi: come si deve comportare una IA? Quali regole deve seguire per non recare danno agli altri?

Negli ultimi sei anni, il dipartimento di polizia della città di New York ha creato un enorme database con nomi e dettagli personali di almeno 17.500 individui che ritiene siano coinvolti in bande criminali.

Ora immaginiamo di adottare la tecnologia di riconoscimento facciale allo sviluppo di un database che teoricamente può predire alcuni comportamenti, riconoscere criminali e chi frequentano.

Benissimo. Ma come si dovrebbe compilare un database del genere? Quali regole dovrebbe seguire nella compilazione e nella privacy?

Spesso si ignorano un paio di domande complicate: chi è in grado di definire la giusta etica e chi dovrebbe farle rispettare?

Questo è importante perché proprio oggi i dipartimenti di polizia negli Stati Uniti, nel Regno Unito e in Cina adottano il riconoscimento facciale come strumento per trovare criminali noti. A giugno, la polizia del Galles ha giustificato l’uso dell’IA per il “beneficio pubblico” che fornisce.

La morale delle macchine è una scienza complicata. I ricercatori del MIT hanno creato una piattaforma chiamata “Moral Machine” per capire l’opinione umana sulle decisioni morali che dovrebbero essere seguite da auto a guida autonoma. (https://beppegrillo.it/moral-machine/)

Chiedendo a milioni di persone da tutto il mondo chi dovrebbe salvare una macchina in un incidente, hanno evidenziato enormi differenze tra culture diverse.

Inoltre stabilire standard etici comunque non cambia necessariamente il comportamento. Un recente studio della North Carolina State University ha scoperto che chiedere agli sviluppatori di leggere e apprendere un codice etico non cambia nulla nel loro comportamento.

Ma qual è la soluzione?

Philip Alston, studioso di giurisprudenza internazionale presso la School of Law della New York University, propone di riformulare l’IA in termini di diritti umani. Quindi se un sistema di intelligenza artificiale elimina i diritti fondamentali delle persone, non dovrebbe essere accettabile, ha affermato Alston.

Alston non è l’unico a proporre questa soluzione.

Anche il Data & Society Research Institute ha proposto l’utilizzo dei diritti umani internazionali per governare l’IA.

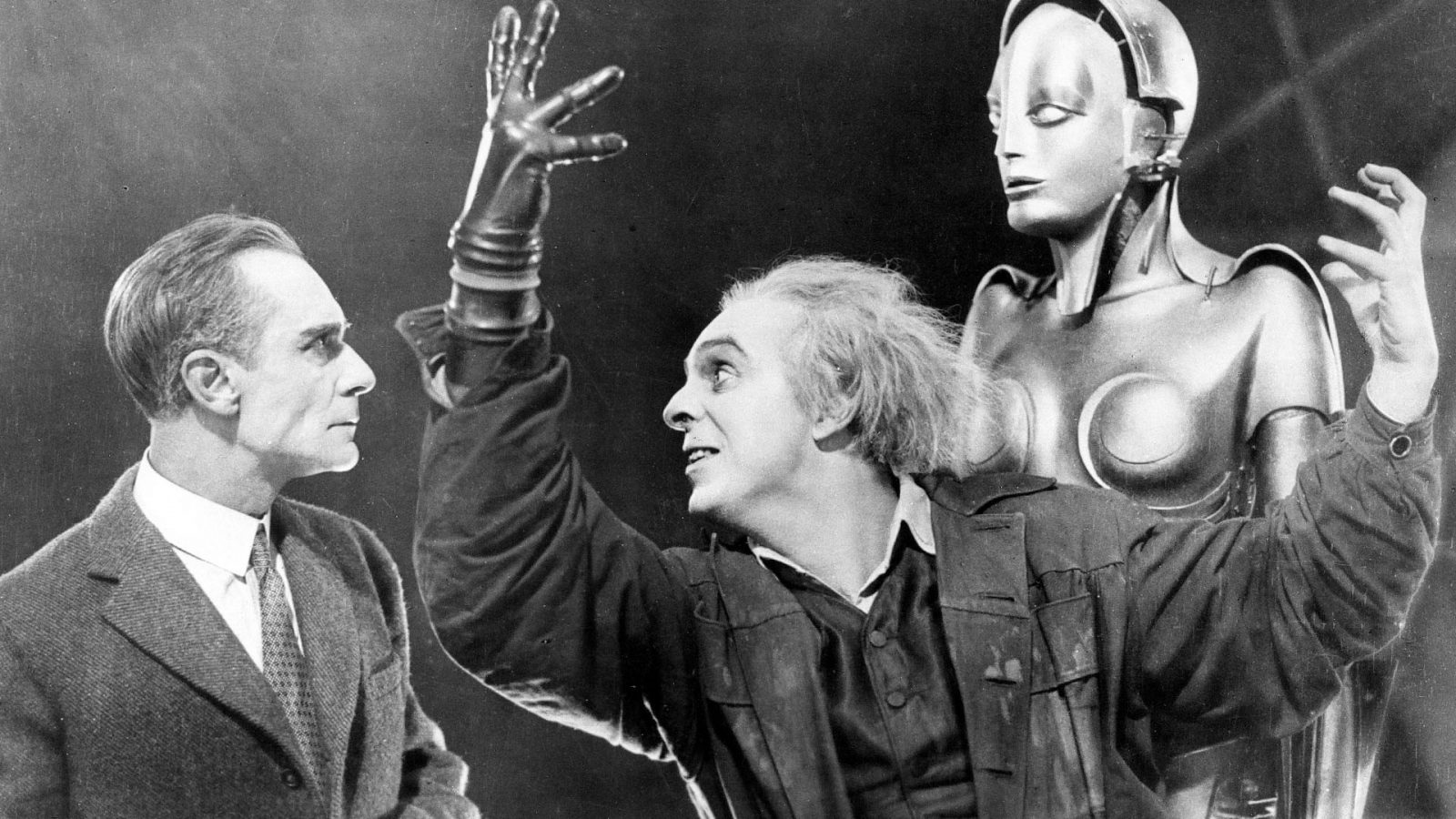

Questo in sostanza vuol dire che oltre al progresso tecnologico, servirà che anche i diritti si muovano verso nuove generazioni, magari includendo ciò che prima era solo ambito della fantascienza.